智通财经APP获悉,有媒体援引知情人士透露的消息报道称,韩国存储巨头SK海力士在周二已开始全面量产用于人工智能芯片(AI 芯片)系统的新一代HBM存储,这也意味着SK海力士未来将在HBM3E领域与美光展开全面竞争。知情人士表示,SK海力士的首批出货将于本月交付给AI芯片霸主英伟达(NVDA.US),英伟达即将量产的基于B100以及H200 这两款全新AI GPU的超级算力体系将搭载SK海力士新一代HBM存储系统。

在全球存储领域,这种名为“HBM3E”的新型高端存储系统可谓是存储市场激烈竞争的核心焦点,HBM存储系统自2023年以来因AI芯片需求而呈现爆炸式增长。而美光和SK海力士一样,均已成为英伟达新款 AI GPU的HBM存储系统供应商,提供的产品均为最新款的“HBM3E”。

在上个月,SK海力士在存储芯片领域的最大竞争者之一美光科技(MU.US)表示已开始大规模量产全新HBM3E存储系统,并且开始陆续交付给英伟达。

在存储芯片领域具备领导者地位的三星电子(Samsung Electronics)所开发的HBM3E虽然未正式获得向英伟达AI GPU供货的资质,但是近日表示已开发出业界的首款12层堆叠36GB的高性能HBM3E存储系统。此外,三星的HBM3存储系统已成功加入英伟达AI芯片组件供应商名单,预计将从第四季度开始供应HBM3存储系统,其供应时间全线晚于SK与美光,且SK与美光已获得英伟达HBM3E认证。

HBM是一种高带宽、低能耗的存储技术,专门用于高性能计算和图形处理领域。HBM堆叠的多个DRAM芯片连接在一起,通过微细的Through-Silicon Vias(TSVs)进行数据传输,从而实现高速高带宽的数据传输。

HBM主要用于高性能图形卡、AI加速、高性能计算和数据中心服务器等领域,其高带宽特性,以及极低延迟和高能效比使得处理器能够更快地访问存储空间,大幅提高计算性能和效率。在AI基础设施领域,HBM存储系统搭配英伟达H100 AI服务器系统,以及即将问世的B100和H200等AI 服务器系统使用。

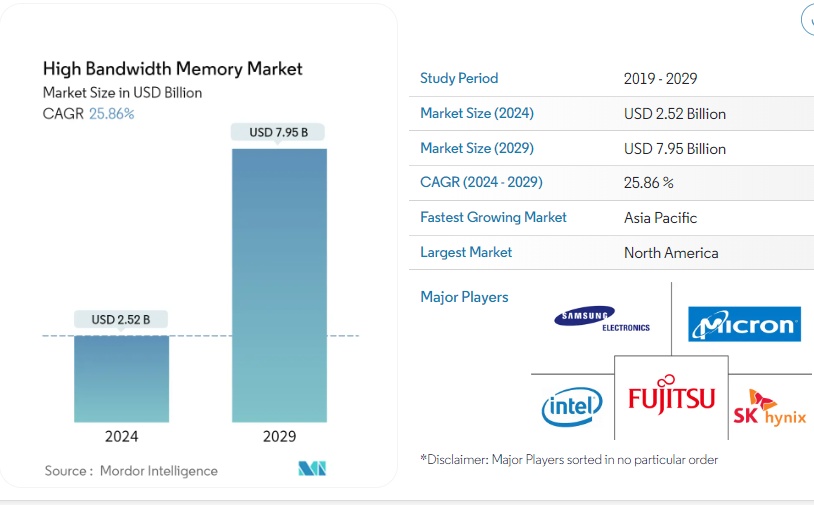

知名研究机构Mordor Intelligence预测数据显示,HBM存储产品的市场规模预计将从 2024年的约 25.2 亿美元激增至 2029年的 79.5 亿美元,预测期内(2024-2029年)复合年增长率高达 25.86%。

SK海力士乃HBM当之无愧龙头! 美光则欲“后发制人”

然而,不可否认的是,虽然在整个DRAM存储领域三星电子乃绝对领导者,但是SK海力士旗下“HBM3版本”的HBM存储系统目前为唯一绑定英伟达H100这一需求极度旺盛的AI GPU的存储系统,SK可谓引领全球HBM存储市场。有统计数据显示,在2023年,英伟达在用于人工智能(AI)训练/推理的AI芯片市场上占据高达90%的份额。

而HBM市场方面,截至2022年,三大原厂HBM市占率分别为SK海力士50%、三星电子约40%、美光约10%,由于SK海力士在HBM领域最早发力,早在2016年已涉足这一领域,因此占据着绝大多数市场份额。有业内人士表示,2023年份额分布将与2022年大致相同。美光在HBM领域的发展相对较晚,但是近期HBM行业的动态消息显示,占据HBM仅10%份额的美光欲“后发制人。

此外,就在SK海力士以及美光先后与AI芯片霸主英伟达敲定HBM3E供应认证之际,三星却意外缺席。据悉,三星最新推出的HBM3E至今仍未通过英伟达的HBM存储品质测试。

美光计划于 2024 年初(大概2月份)开始大批量生产HBM3E 新型存储产品,并开始陆续交付,同时还透露英伟达是其新型 HBM存储产品的主要客户之一。此外,该公司强调其全新HBM产品受到了整个行业的极大兴趣,这暗示英伟达可能不是唯一最终使用美光 HBM3E 的大型客户。美光显然对 HBM3E 寄予厚望,因为这可能使其能够领从SK海力士以及三星电子手中不断赢得市场份额,以全面提高公司营收和利润。

根据一些业内人士爆料,美光的HBM3E将支持英伟达搭载HBM3E的新款AI硬件体系——Grace Hopper GH200 超级算力体系(该算力体系配备基于 H100 计算 GPU 和 Grace CPU),这表明美光在HBM领域的最新进展不仅是技术上的全面突破,也是其与英伟达合作深化的体现。据业内人士透露,英伟达即将发布的基于B100以及H200 GPU的超级算力体系可能也将搭载美光HBM3E。

美光HBM3E 模块基于八个堆叠 24Gbit 存储芯片,采用该公司的 1β (1-beta) 制造工艺制造。这些模块的数据速率高达 9.2 GT/秒,使每个堆栈的峰值带宽达到 1.2 TB/s,比目前最快的 HBM3 模块提高了 44%。与此同时,该公司不会停止其基于 8-Hi 24 Gbit 的 HBM3E 组件。该公司宣布,继开始量产 8-Hi 24GB 堆栈后,计划于 2024 年推出超大容量 36 GB 12-Hi HBM3E 堆栈。

美光还表示,其最新款的HBM3E的功耗将比竞争对手产品低 大约30%,有助于满足为大型生成式 AI 应用提供计算动力的AI芯片不断增长的存储需求。

SK海力士欲巩固HBM龙头地位

“公司希望HBM3E能够不久后成功量产,凭借我们的经验,作为业界首家HBM3供应商,我们希望巩固我们在人工智能HBM存储领域的领导地位。”SK海力士在一份声明中表示。

性能方面,世界第二大存储芯片制造商SK海力士最新推出的新型HBM3E存储系统在散热方面提高了10%,每秒处理数据的速度则高达1.18 tb;SK海力士HBM3E提供高达8Gbps的传输速度,相较于前一代HBM3显著提升;对于使用1024-bit 宽存储器总线的单个HBM堆栈,将提供大约1TB/秒带宽的HBM3E的KGSD,高于前一代HBM3的819.2GB/秒带宽。

业内的一些分析人士表示,SK海力士2024年的HBM产能可能已被预订满,因为全球数据中心以及科技企业对人工智能芯片组的爆炸性需求推高了对其中使用的高端HBM存储系统的强劲需求。

无独有偶,美光高管也表示,美光HBM3E2024年需求无比强劲。美光首席执行官Sanjay Mehrotra在第一财季业绩会议上表示,数据中心用于帮助开发人工智能软件/应用程序的高端存储芯片需求异常强劲。 Mehrotra还强调道,美光已经彻底售罄预计在2024年产能能够生产的所有HBM。“这就是创建人工智能软件的计算机所需要的超快访问芯片类型。AI给我们所带来的高营收、高利润机会才刚刚开始。”Mehrotra表示。

从市场策略的角度来看,SK海力士凭借作为目前绑定英伟达AI GPU的HBM3存储的唯一供应商,已经在HBM存储市场上确立了领导地位,并且其HBM产能已经预订满2024年。美光则通过其HBM3E产品的能效和领先全球同行的性能优势,尝试在高端内存市场中取得竞争优势,并且已经在行业内受到了极大的关注和兴趣。

“SK海力士在HBM存储领域可以说已经获得领先的市场地位,预计其高端存储系统的产量增长规模也将是芯片制造商中最激进的。”IBK Investment & Securities分析师Kim Un-ho表示。

英伟达于美东时间周一发布了其最新的旗舰款人工智能GPU——B100 AI GPU,据称在某些任务上比其前代AI GPU快将近30倍,以强势捍卫其在人工智能芯片领域的绝对主导地位。B100背后的Blackwell架构成本和能耗较前代改善25倍,为全球最强大AI GPU,由 2080 亿个晶体管组成,采用台积电4NP制程,支持多达10万亿参数的模型进行AI训练和实时大语言模型(LLM)推理。

由于在HBM芯片领域的领先地位,SK海力士的股价在过去12个月里翻了一番。截至上周五收盘,美光过去12个月的涨幅超过70%,本月早些时候,随着分析师们强调该存储巨头在人工智能热潮中的重要地位,该公司股价在今年达到创纪录的历史高点。