智通财经APP获悉,CPU与GPU双产业巨头、英伟达(NVDA.US)竞争对手之一AMD(AMD.US)于美东时间周三举行“Advancing AI”发布会,AMD宣布正式推出其旗舰款AI GPU加速器MI300X,意味着AMD与英伟达之间的激烈竞争从PC领域全面延伸至AI领域,AMD测试数据显示其整体性能比英伟达H100高出60%。除了如预期发布诸如Instinct MI300X、MI300A等新产品外,在AI领域的一些全球领军者也来到现场,比如OpenAI、微软以及Meta,并表示他们后续将大量配置AMD Instinct MI300X。

“Advancing AI”发布会上,首先登场的是Instinct MI300X加速器,由于MI300系列AI芯片的参数在半年前的产品宣传活动上就已经公布,本次“Advancing AI”发布会更多聚焦于整套系统在实际应用中的表现,以及与AI训练/推理领域热度最高的英伟达H100 AI芯片的全方位性能对比。此外,AMD将截至2027年的全球AI芯片市场规模预期,从1500亿美元猛然上修至4000亿美元。

AI领域的全球领军者OpenAI、微软(MSFT.US)以及Meta(META.US)周三在AMD活动上表示,他们将使用AMD最新的AI芯片Instinct MI300X。这是迄今为止全球科技公司正在寻找昂贵的英伟达H100 AI芯片替代品的最明显迹象。英伟达H100对于创建和部署OpenAI旗下的ChatGPT等生成式人工智能(生成式AI)应用程序至关重要,如今AI芯片领域几乎处于垄断地位的英伟达H100终于有了强力竞争对手,那就是AMD Instinct MI300X。

如果AMD最新的高端AI芯片在明年初开始出货时,足以满足构建人工智能大模型的科技公司和云服务提供商的算力需求,同时降低科技公司开发人工智能模型的成本,势必将对英伟达旗下销售额不断飙升的AI芯片构成巨大的竞争压力。

AMD首席执行官苏姿丰(Lisa Su)周三表示:“潜在大客户的所有兴趣基本上集中在云计算领域的大型处理器和大型GPU上。”

AMD表示,MI300X基于一种全新的架构,这种架构通常会带来显著的性能提升。AMD 全新AI芯片最显著的特点是拥有192GB的尖端高性能HBM3内存,传输数据速度更快,可以适应更大规模的人工智能模型。

被AMD粉丝们亲切称为“苏妈”的苏姿丰在发布会上直接将MI300X及其构建的系统与英伟达的主要AI芯片H100进行了比较。“这种性能直接转化为更好的用户体验,”苏姿丰表示。“当你向模型提出要求时,你希望它能更快地回复,尤其是在反应变得更复杂的情况下。”

AMD面临的主要问题在于,一直以英伟达软硬件为基础的公司是否会投入时间和金钱来信任另一家AI芯片供应商。AMD周三告诉投资者和合作伙伴,该公司已经改进了名为ROCm的配套软件套件,以与英伟达的行业标准CUDA软件相竞争,一定程度上解决了AMD在AI芯片领域面临的一个关键缺陷——那就是软硬件生态系统,而这个缺陷一直是人工智能开发者目前更喜欢英伟达旗下产品的主要原因之一。

AMD在周三并未透露MI300X的定价,但英伟达AI芯片每块售价高达4万美元,苏姿丰表示,AMD的芯片必须比英伟达的芯片购买和运营成本更低,才能说服潜在大客户购买。

虽然发布会的内容基本上符合市场预期,但似乎未提振AMD股价。在周三美股科技股集体走弱的背景下,AMD发布会还没开完,股价就由涨转跌,最终收跌超1%,但是盘后涨幅超过1%。

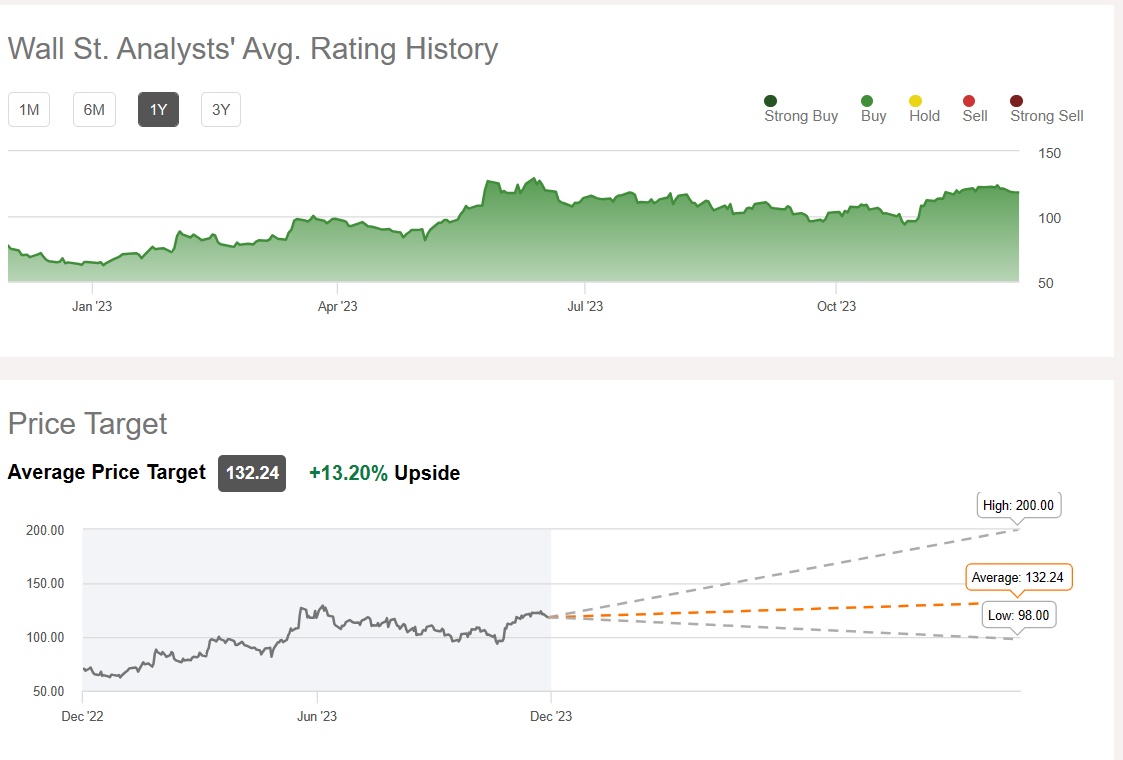

由于AMD即将推出与英伟达H100相抗衡的高性能AI 芯片,华尔街分析师们对于AMD股价普遍看涨,Seeking Alpha汇编的华尔街分析师共识评级以及目标价显示,华尔街分析师们对AMD的共识评级为“买入”,平均目标价预期达132.24美元,意味着未来12个月潜在涨幅高达13%,最高目标价则为200美元。

性能强于英伟达H100! AMD大幅上调市场规模预期

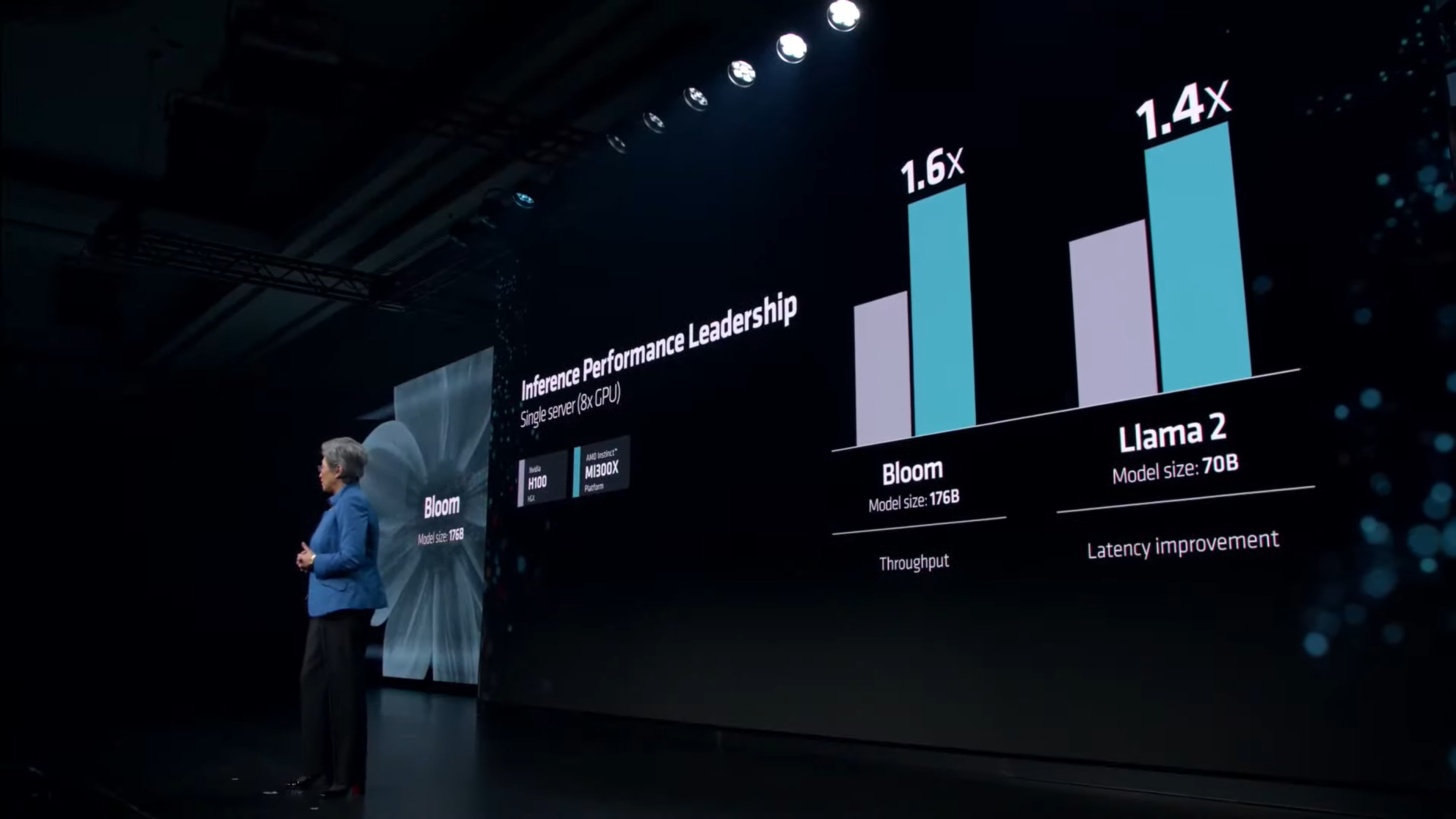

与AI训练/推理领域热度最高的英伟达H100 AI芯片的最新性能对比数据显示,在一般LLM内核TFLOP中,MI300X在FlashAttention-2和Llama 2 70B中提供较英伟达H100高达20%的性能提升幅度。从平台的角度来看,将8x MI300X解决方案与8x 英伟达H100解决方案进行比较,AMD发现Llama 2 70B的增益程度要大得多,高达40%,Bloom 176B基准下的增益程度则高达60%。

具体的AMD Instinct MI300X与英伟达H100性能对比数据显示:

在1v1比较中,整体性能比H100 (Llama 2 70B)提高20%

在1v1比较中,整体性能比H100 (FlashAttention 2)提高20%

8v8 服务器中的整体性能比 H100 (Llama 2 70B) 提高40%

在8v8服务器中,整体性能比 H100 (Bloom 176B) 提高60%

最新 MI300 AI芯片背后的驱动力是AMD ROCm 6.0。该软件堆栈已更新到最新版本,具有强大的新功能,包括支持各种人工智能工作负载任务量,例如生成式人工智能和大语言模型(LLM)。

内存是AMD另一个巨大的升级领域,MI300X的HBM3容量比其前身MI250X(128 GB)增加了50%。为了实现高达192GB的内存池,AMD为MI300X配备了8个HBM3堆栈,每个堆栈都是12-Hi,同时整合了16Gb IC,每个IC具有2GB容量,或每个堆栈具有高达24GB的容量。

该级别的内存规模将提供高达5.3TB/s的带宽和896GB/s的Infinity Fabric带宽。相比之下,英伟达即将推出的H200 AI芯片提供141GB容量,而英特尔Gaudi3 将提供141GB容量。功耗方面,AMD Instinct MI300X的额定功率为750W,比Instinct MI250X的500W提升了50%,比NVIDIA H200多了50W。

AMD在周三对AI芯片领域的未来市场规模给出了大胆的预测数据,认为AI芯片市场将迅猛扩张。具体来说,AMD预计AI芯片市场整体规模到2027年将达到超过4000亿美元,较该公司几个月前提供的1500亿美元上调将近两倍,凸显全球各大企业对人工智能硬件的预期快速变化,各企业正在迅速布局全新的AI产品。

有哪些科技巨头将使用MI300X?

AMD在周三的发布会上表示,该公司已经与一些最需要GPU的科技公司签订了使用该芯片的协议。根据研究公司Omidia最近的一份报告,Meta和微软是2023年英伟达H100 AI芯片的最大规模买家。

在发布会上,Facebook和Instagram母公司Meta公开表示,该公司未来将大量使用MI300X GPU处理人工智能推理工作负载,如处理人工智能贴纸、图像编辑和操作其AI助手,并表示结合ROCm 软件堆栈来支持AI推理工作负载。

微软首席技术官Kevin Scott公开表示,微软将通过其Azure网络服务提供对MI300X芯片的技术访问通道。此外,同日消息显示,微软未来将评估对AMD的AI芯片产品的需求,评估采用该新品的可行性。

ChatGPT开发商OpenAI表示,该公司将在一款名为Triton的重要软件产品中支持AMD MI300等GPU。Triton不是像GPT-4那样的大语言模型,但对于人工智能研究领域来说是非常重要的产品。

英伟达最大规模客户之一甲骨文表示,将在自己的云计算服务体系中使用Instinct MI300X加速器,并计划基于AMD Instinct MI300X开发生成式AI服务。

AMD目前还没有预测该AI芯片的长期销售额,目前只给出了2024年预期,预计2024年数据中心GPU带来的总营收规模约为20亿美元。仅在最近一个季度,英伟达的数据中心业务营收就超过140亿美元,不过这一数据还包括GPU以外的业务。然而,AMD表示,未来四年,AI芯片领域的总市场规模可能将攀升至4000亿美元,是该公司此前预测值的两倍。

苏姿丰还向记者表示,AMD并不认为它需要击败英伟达才能在市场上取得好成绩。在谈到人工智能芯片市场时,苏姿丰对记者表示:“我认为很明显,英伟达现在占据绝大多数。”“我们认为,到2027年,AI芯片市场规模可能会超过4000亿美元,而我们将扮演重要角色。”