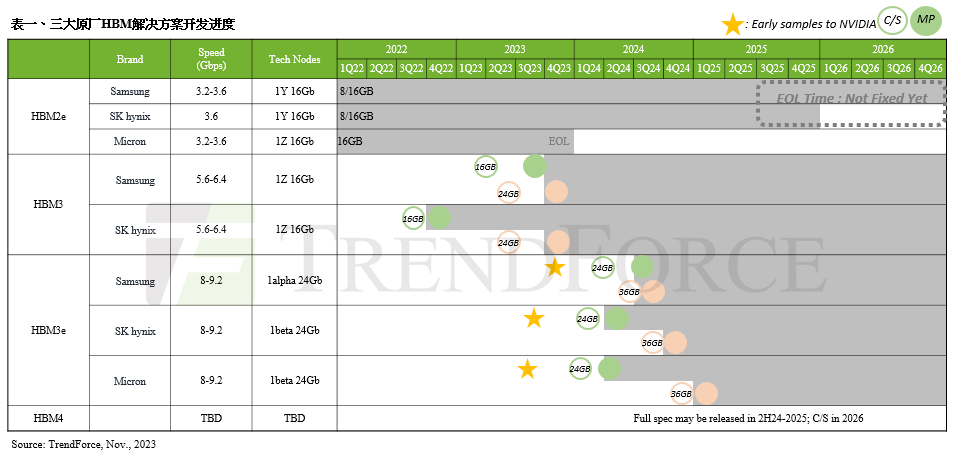

智通财经APP获悉,据TrendForce集邦咨询最新HBM市场研究显示,为了更妥善且健全的供应链管理,NVIDIA(NVDA.US)也规划加入更多的HBM供应商,其中三星的HBM3(24GB)预期于今年12月在英伟达完成验证。而HBM3e进度依据时间轴排列如下表所示,美光(MU.US)已于今年7月底提供8hi(24GB)NVIDIA样品、SK海力士已于今年8月中提供8hi(24GB)样品、三星则于今年10月初提供8hi(24GB)样品。

NVIDIA持续扩展AI芯片产品 在高端芯片市场拥最大优势

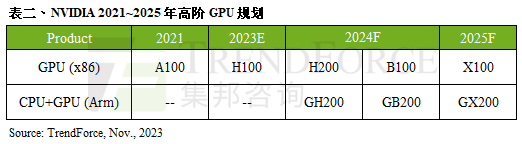

展望2024年,观察目前各AI芯片供应商的项目进度,NVIDIA 2023年的高端AI芯片(采用HBM)的既有产品为A100/A800以及H100/H800;2024年则将把产品组合(Product Portfolio)更细致化的分类。除了原上述型号外,还将再推出使用6颗HBM3e的H200以及8颗HBM3e的B100,并同步整合NVIDIA自家基于Arm架构的 CPU与GPU,推出GH200以及GB200。

相比同时期的AMD(AMD.US)与Intel(INTC.US)产品规划,AMD2024年出货主流为MI300系列,采用HBM3,下一代MI350将采用HBM3e,预计2024下半年开始进行HBM验证,实际看到较明显的产品放量(Ramp

Up)时间预估应为2025年第一季。

以Intel Habana来看,2022下半年推出的Gaudi 2采用6颗HBM2e,2024年中预期在新型号Gaudi 3持续采取HBM2e,但将用量升级至8颗。因此,TrendForce集邦咨询认为,NVIDIA在HBM规格、产品准备度(Readiness)及时间轴上,可望持续以领先的GPU规格,在AI芯片竞局取得领先。

HBM4或将转向客制化 摆脱Commodity DRAM产品框架

除了HBM3与HBM3e外,据TrendForce集邦咨询了解, HBM4预计规划于2026年推出,目前包含NVIDIA以及其他CSP(云端业者)在未来的产品应用上,规格和效能将更优化。受到规格更往高速发展带动,将首次看到HBM最底层的Logic die(又名Base die)采用12nm制程wafer,该部分将由晶圆代工厂提供,使得单颗HBM产品需要结合晶圆代工厂与存储器厂的合作。

再者,随着客户对运算效能要求的提升,HBM4在堆栈的层数上,除了现有的12hi (12层)外,也将再往16hi (16层)发展,更高层数也预估带动新堆栈方式hybrid bonding的需求。HBM4 12hi产品将于2026年推出;而16hi产品则预计于2027年问世。

最后,TrendForce集邦咨询也观察到,针对HBM4,各买方也开始启动客制化要求,除了HBM可能不再仅是排列在SoC主芯片旁边,亦有部分讨论转向堆栈在SoC主芯片之上。虽然目前所有选项仍在讨论可行性中,并尚未定案,但TrendForce集邦咨询认为,未来HBM产业将转为更客制化的角度发展,相比其他DRAM产品,在定价及设计上,更加摆脱Commodity DRAM的框架,呈现特定化的生产。