智通财经APP获悉,今天(11月27日),范式智能对外宣布,「信创模盒」ModelHub XC上线两个月,已完成适配并认证的模型数量破千,比原计划提前了4个月,国产信创AI生态在模型覆盖广度上取得显著进展,并将持续为产业智能化转型提供更为坚实与丰富的模型基座。

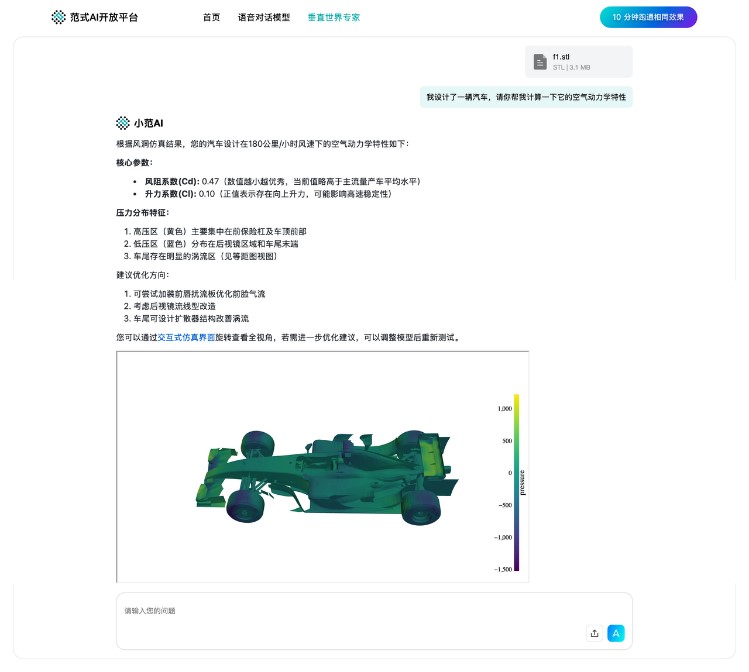

「信创模盒」ModelHub XC当前已覆盖从通用大语言模型(如DeepSeek V3.1)、垂直领域专业模型(如风洞计算大模型)到前沿创新模型(如gpt-oss-20B,MiniMax-M2)的多元化品类,功能强大、生态日趋完善,为国产AI软硬件协同发展提供了坚实基础。

在平台发展脉络中,几个关键节点尤为突出,清晰勾勒出其持续突破的技术路径:

2025-9-22启动上线

当大模型运行的显存不足困境被逐步破解,AI产业发展的新矛盾已然浮现:部署的模型与底层芯片架构互不兼容,采购的硬件缺乏充分适配的模型生态。这种“算力—模型”的二元割裂,正成为制约AI规模化落地的隐形天花板。

直面这一行业核心痛点,范式智能于今年9月22日正式上线「信创模盒」ModelHub XC平台、信创社区及信创模型适配增值服务,致力于打破客户、算力与开发者之间的屏障。上线当天,范式智能创始人戴文渊出席并讲话,范式智能联合创始人、首席科学家陈雨强与华为昇腾、壁仞科技、天数智芯、昆仑芯、摩尔线程、曦望等头部国产芯片厂商一起,启动「信创模盒」ModelHub XC上线,并同步推出信创社区与模型适配增值服务,直面国产算力与模型适配难题。

2025-10-17 攻克垂直领域复杂模型

在国产芯片曦望S2上完成风洞计算大模型的完整适配与深度优化。

·首例商用级适配:完成业内首次在国产芯片上对垂直领域复杂大模型的完整适配,达到可商用、可部署的生产级性能标准

·性能比肩国际主流:实现单张图处理时间约1.5秒,与当前国际主流高端GPU性能持平

·突破关键领域瓶颈:为关键领域计算基础设施自主化奠定了坚实基础

2025-11-1 适配前沿全模态OCR模型

完成创新模型DeepSeek-OCR在昇腾、沐曦等信创算力卡上的适配测试。

·技术创新价值突出:该模型开创性地利用视觉模态压缩文本信息,是破解大语言模型长上下文效率难题的关键探索。

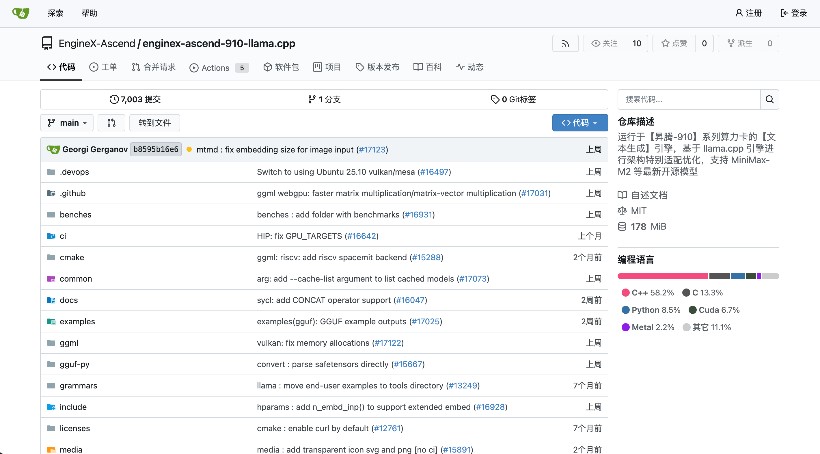

·架构级适配路径贯通:基于EngineX体系对Transformer架构的底层支持,实现了模型在信创环境下的高效、稳定推理。

·输出效果与性能兼具:模型输出效果与NVIDIA平台完全一致,推理性能差距控制在30%以内,达到可用、好用标准。

2025-11-17 部署高效开源Agent模型

在昇腾910B4芯片上完成高效Agent模型MiniMax-M2的适配。

·模型能力全球领先:适配模型MiniMax-M2为顶尖开源Agent模型,采用MoE架构,总参数量2300亿,在代码与智能体任务上表现卓越。

·实现“即插即用”部署:通过EngineX对GGML/MoE架构的深度优化,实现了该复杂模型在国产算力上的稳定推理与快速部署。

·夯实企业应用基座:为企业在国产化环境中构建和部署复杂的AI Agent应用提供了可靠、高性能的模型选择。

2025-11-25 实现百模批量适配与量化优化

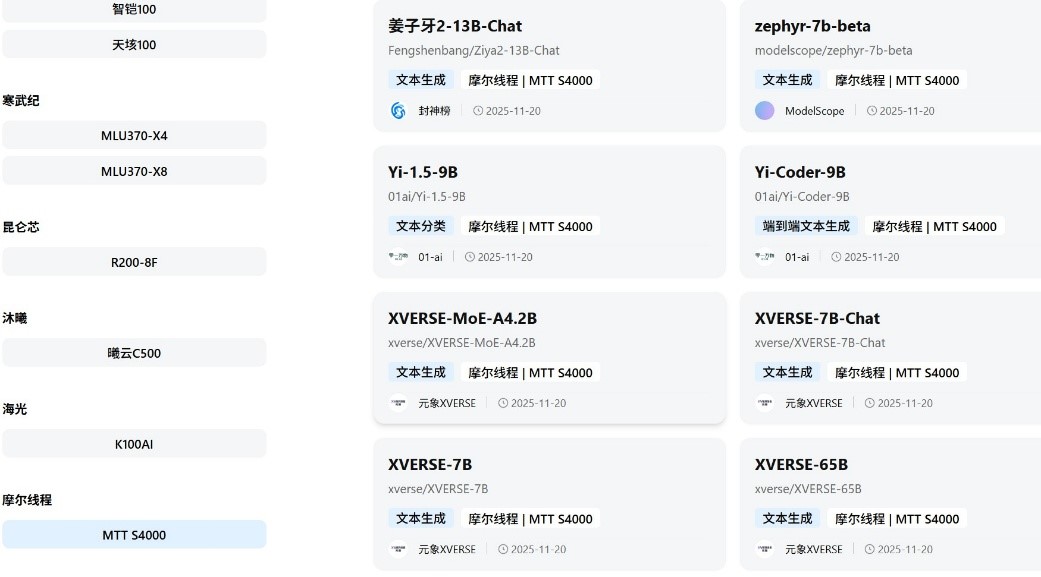

平台在摩尔线程芯片上实现108个模型的规模化适配,展现出强大的生态拓展能力。

·规模化适配成效显著:一次性完成108个模型适配,广泛覆盖文本生成、视觉理解、多模态问答等多种任务类型。

·硬件量化优势凸显:充分释放摩尔线程GPU在低精度计算与缓存优化上的硬件潜力,显著降低显存占用并提升推理速度。

·生态动能持续注入:此次批量适配标志着平台具备规模化交付能力,并为未来半年内扩展至千量级模型库奠定坚实基础。

平台核心能力:引擎驱动,模型适配破千

「信创模盒」ModelHub XC 不仅是模型仓库,更是以“EngineX引擎+批量适配”为核心的高能社区,致力于打通国产算力与AI模型之间的关键通路。目前,平台已完成超过1000个模型的适配认证,标志着国产信创模型生态建设迈入规模化新阶段。

平台核心能力包括:

EngineX引擎驱动:通过基础算法架构的深度适配,实现模型在国产芯片上的“即插即用”,极大缩短部署周期,解决兼容性瓶颈。

模型生态丰富多元:已覆盖从通用大模型、垂直领域模型到前沿创新模型的多元化品类,并广泛支持华为昇腾、寒武纪、天数智芯、昆仑芯、摩尔线程、沐曦、曦望等主流国产算力。

适配标签清晰直观:每个模型均标注可运行的芯片型号,支持用户快速匹配模型与算力。

专业服务全程兜底:提供「信创模型适配增值服务」,由数百人工程师团队支撑,确保指定模型在国产环境中的成功适配与稳定运行。

展望未来:共建十万级信创模型生态

平台已按原计划提前4个月达成“千模适配”里程碑,未来将加速向“万模互联”迈进:

一年之内,冲刺十万模型:持续扩展模型规模与芯片支持范围;

持续高速迭代:保持快速更新节奏,构建更完整、更高效的国产AI基础设施。